近日,NVIDIA公布了2023 财年及其Q4财报。在加密货币低迷、消费需求疲软、去库存的种种压力下,NVIDIA在2023 财年的总营收基本与上一财年持平,约为270 亿美元。其中,Q4营收为60.5 亿美元,较去年同期下降了21%。

尽管如此,其业绩表现依然好于分析师此前的预期。财报发布当天,NVIDIA股价大涨14%,市值达到5800 亿美元。事实上,人们对NVIDIA的乐观情绪已经蔓延数月。自今年1 月以来,NVIDIA的市值涨幅最高达60%。

这多亏了OpenAI,其发表的ChatGPT 和DALL-E 2 这样的大型语言模型(Large Language Model)将生成式AI 引入了公众的视线——几乎所有软体将被AI 重塑,黄仁勋更是将其比作「AI 的iPhone 时刻」。

就此,时代的风口由元宇宙和web3 突然切换到生成式AI,FAAMG 等矽谷巨头们匆忙备战随时「开打」。而NVIDIA,稳稳地成为这场时代之战的「最大军火商」。

作为当下「AI 超级周期的跳动心脏」,NVIDIA的GPU(图形处理晶片)是训练和操作机器学习模型的最佳选择,因而被视为「2023 年云端资本支出重心转向人工智慧的最大受益者」。

其实,这不是NVIDIA第一次乘上时代的风车——加速运算、深度学习、挖矿、元宇宙,NVIDIA屡次踩中时代的风口。在它成立的短短30 年里,晶片江湖已然换了人间,当年与90 家显示卡商厮杀落败的初创公司,早已成为市值最高的晶片霸主。

NVIDIA屡次「躺赢」,离不开其掌舵者黄仁勋的战略眼光——总是能精准预判下一个技术变革,提前下手。在近日的财报电话会上,黄仁勋透露了:这一次,他提前看到的未来及其相应的战略布局。面对大语言模型加持的生成式AI,「核弹厂」的野心远非提供「军火」。

ChatGPT 大战背后的「战争之王」

去年11 月底以来,OpenAI 让人们见识到了「通用智慧」的厉害,依托大语言模型的ChatGPT 所展现的思维链条(Chain of Thought)和自发涌现的各种能力(Emergence)令人惊艳——尽管ChatGPT 本身没有知识和智慧,但是它做到了「让你以为它有知识甚至智慧」的程度。

不久前,在加州大学柏克莱分校哈斯商学院的炉边谈话上,黄仁勋兴奋地评价ChatGPT 将开启科技行业的新纪元,也是人工智慧和计算行业有史以来最美妙的事情。

他说:「上一次看到一项如此多才多艺、可以解决问题并经常以多种方式带给人们惊喜的科技是什么时候?它可以写一首诗,可以填写试算表,可以编写SQL 查询并执行,可以写Python 程式码……对于很多一直致力于此的人来说,我们一直在等待这一刻,这是人工智慧的iPhone 时刻。我现在可以将它用作API 并连接到试算表、PPT、各个应用程式,它有让一切变得更好的潜力」。

这是「AI 将重塑所有软体」的际遇,而要让生成式AI 能够像ChatGPT 这样展现五花八门的通识才能,必须依托像GPT3.5 这样的底层大语言模型。人们将其比作行动网路时代里Android或iOS。因此,大语言模型也就成为大厂和创业公司的必争之地。

无论是「造」出这样一个大模型,还是运行这样一个大模型,都需要极大的算力,需要成千上万个GPU。据报导,OpenAI 用了10000 个NVIDIA的GPU 来训练ChatGPT。花旗集团估计,ChatGPT 的使用可能会在12 个月内为NVIDIA带来30 亿至110 亿美元的销售额。

此前业内人士表示,「大模型技术涉及AI 开发、推理、训练的方方面面,所谓模型的『大』主要是参数量大、运算量大,需要更大体量的资料和更高的算力支撑。对于GPU 厂商来说,大模型是值得期待的算力红利,尤其是通用性极强的NVIDIA」。

全球来看,大算力晶片领域主要有两个玩家,NVIDIA和AMD,从市占率来说,NVIDIA远超AMD。根据John Peddie Research 的资料,NVIDIA占据了GPU 市场约86% 的市场占有率。

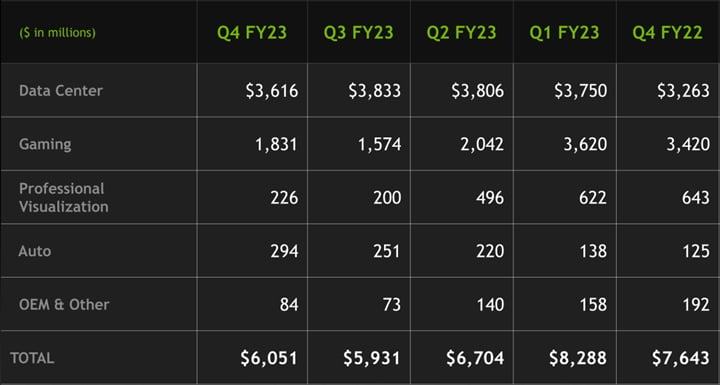

这也就不难理解,在炙手可热的生成式AI 浪潮下,NVIDIA被视为最大的潜在赢家。从财报上看,这波生成式AI 对于NVIDIA的需求主要反映在资料中心业务。事实上,2023 整个财年的四个季度,资料中心已经替代了NVIDIA起家的支柱业务——游戏,成为第一大业务。

▲ 2022 财年第4 季度——2023 财年第4 季度,NVIDIA各个板块的营收| 截图来源:Nvidia

2023 财年,资料中心总收入增长了41%,达到创纪录的150.1 亿美元。仅就Q4而言,资料中心收入为36.2 亿美元,贡献了NVIDIA全公司收入的60% 左右。

资料中心增长的基本盘来自于新一代旗舰产品H100 的出货量持续走高、云端的渗透率持续增长、以及超大规模客户扩大了AI 布局。

就H100 而言,其收入在Q2就已经远远高于A100,后者的营收占有率连续下降。据悉,H100 在训练方面比A100 快9 倍,在基于Transformer 的大型语言模型推理方面比A100 快30 倍。

同时,NVIDIA正在为越来越多的、快速增长的云端服务商(Cloud Service Providers,简称CSP)提供服务,包括甲骨文和一些专注于GPU 的云端服务提供者(GPU specialized CSPs)。在过去的4 个季度中,CSP 客户贡献了资料中心收入的40% 左右。

下一步:AI 即服务

财报电话会上,老黄透露了NVIDIA的新动向——AI企业级服务上云端。尽管更多资讯会在十几天后的GTC 大会上才宣布,但NVIDIA正与领先的云端服务商合作提供AI 即服务(AI-as-a-service),让企业可以造访NVIDIA的AI 平台。据官方消息,客户将能够把NVIDIA AI 的每一层(包括AI 超级电脑、加速库软体或预训练的生成式AI 模型等)作为云端服务来使用。

老黄阐述道,「技术突破的积累使AI 到了一个反曲点。生成式AI 的多功能性和能力引发了世界各地企业开发和部署AI 战略的紧迫感。然而,AI 超级电脑基础设施、模型演算法、资料处理和训练技术仍然是大多数人无法克服的障碍。」

基于这样的行业痛点,NVIDIA商业模式的下一个层次是:说明每个企业客户都能使用AI。

客户使用自己的浏览器,就可以透过NVIDIA DGX Cloud 来使用NVIDIA DGX AI 超级电脑,该服务已经在Oracle Cloud Infrastructure 上可用,预计不久后也将在Microsoft Azure、Google Cloud 和其他平台上线。在AI 平台软体层,客户将能够造访NVIDIA AI Enterprise,以训练和部署大型语言模型或其他AI 工作负载。而在AI 模型即服务层,NVIDIA将向希望为其业务建立专有生成式AI 模型和服务的企业客户提供NeMo 和BioNeMo 可定制AI 模型。

就其市场前景,黄仁勋认为,ChatGPT 让人们意识到电脑程式设计的民主化,几乎任何人都可以用人类语言向机器解释要执行的特定任务。因此,全世界AI 基础设施的数量将会增长,「你会看到这些AI 工厂无处不在」。人工智慧的生产将会像制造业一样,在未来,几乎每个公司都会以智慧的形式生产软体产品。资料进来了,只做一件事,利用这些资料产生一个新的更新模型。

他进一步解释了AI 工厂,「当原材料进入时,建筑或基础设施就会启动,然后一些改进的东西就会出现,这是非常有价值的,这就是所谓的工厂。所以我希望在世界各地看到AI 的工厂。其中一些将托管在云端中。其中一些将是本地的。会有一些很大,有些会非常大,然后会有一些更小。所以我完全期待这会发生。」

事实上,老黄关于AI 工厂愿景正在发生,上个月,他在公开演讲中声称,自从ChatGPT 出现以来,可能已经有大约500 家新创业公司开发出令人愉快的、有用的AI 应用程式。

基于这一前景,NVIDIA对资料中心的未来充满信心。 CFO Cress 表示,透过新的产品周期、生成式AI 以及人工智慧在各个行业的持续采用,资料中心部门将持续实现增长。她说:「除了与每个主要的超大规模云端服务商合作外,我们还与许多消费网路公司、企业和初创企业合作。这一机会意义重大,推动资料中心的强劲增长,并将在今年加速增长。」

汽车向上,游戏向下

除了资料中心,NVIDIA其他的业务板块——游戏、汽车、专业视觉等,本季度的表现则有好有坏。

其中,车用业务表现亮眼。财年总收入增长60%,达到创纪录的9.03 亿美元。 Q4收入创下2.94 亿美元的纪录,较去年同期增长135%,较上一季度增长17%。

无论是和上个周期对比还是去年同期对比,车用业务均持续增长。根据NVIDIA,这些增长反映了自动驾驶解决方案的销售增长,面向电动汽车制造商的计算解决方案以及AI 座舱解决方案的销售强劲。电动汽车和传统OEM 客户的新专案助推了这一增长。

值得注意的是,在今年1 月初举行的CES 大会上,NVIDIA宣布与富士康建立战略合作伙伴关系,共同开发基于NVIDIA DRIVE Orin 和DRIVE Hyperion 的自动驾驶汽车平台。

相比之下,游戏业务依然深处泥潭之中。

过去几个季度,RTX 4080 销售疲软、电玩游戏行业下滑、加密货币市场疲软、以及去库存压力等因素,让NVIDIA的游戏业务持续低迷,尤其Q3,游戏业务营收同期对比暴跌51%。但就像CFO Cress 所言,「最低点可能已经过去,而且事情可以改善前进。」

Q4,NVIDIA游戏营收为18.3 亿美元,同期对比下降46%,周期对比增长16%,整个财年收入下降27%。该季度和财年的同期对比下降反映了销售减少,背后是全球宏观经济低迷和中国放开疫情管控对游戏需求的影响。

但Q3和上期统计周期相比,NVIDIA的游戏业务还是有一定增长。这是由于受到基于Ada Lovelace 架构的新GeForce RTX GPU 的推出推动。黄仁勋也肯定了这一看法,他说:「游戏业正在从新冠肺炎疫情后的低迷中复苏,而且玩家们热烈欢迎使用AI 神经算绘的Ada 架构GPU。」

近日,游戏行业一个复苏的好迹象是:动视暴雪(Activision Blizzard)在Q4实现了营收正增长,超出了预期。但仍要警惕——动视暴雪在PC 和主机上销售游戏,而只有PC 销售与NVIDIA相关,主机制造商使用AMD 显示卡。

此外,在财报发布的前一天,NVIDIA宣布与微软签订了一项为期10 年的协议,将Xbox PC 游戏阵容引入GeForce NOW,包括《我的世界(Minecraft)》、《最后一战(Halo)》和《微软模拟飞行(Microsoft Flight Simulator)》。待微软完成收购动视之后,GeForce NOW 将新增《决胜时刻(Call of Duty)》和《斗阵特攻(Overwatch)》等游戏。

除了游戏业务之外,专业视觉和OEM 这两个部门的业务也较上一年有大幅下降。从中可以看出:半导体市场正在经历罕见的下行周期。

专业视觉业务Q4收入为2.26 亿美元,较去年同期下降65%,较上一季度增长13%。财年总收入下降27% 至15.4 亿美元。该季度和财年同期对比下降反映了向合作伙伴销售较少以帮助减少管道库存。周期对比增长是由台式工作站GPU 推动的。

OEM 和其他收入同期对比下降56%,周期对比增长15%。财年收入下降61%。该季度和财年同期对比下降是由笔记型电脑OEM 和加密货币挖掘处理器(CMP)推动的。在财年2023 中,CMP 收入微不足道,而在财年2022 中为5.5 亿美元。

风口上的赢家,为什么又是NVIDIA

NVIDIA 30 年的发展史可以分为两段。从1993 年到2006 年,NVIDIA的目标是在竞争激烈的图形卡市场中存活下来,并创造了GPU 这一革命性的技术;从2006 年到2023 年的转型,则主要是如何利用CUDA 这一平台,将GPU 应用于机器学习、深度学习、云端运算等领域。

后者让NVIDIA走上人工智慧之旅,今天市值已经超过老牌霸主英特尔和AMD,也是在今天生成式AI 热潮下,NVIDIA再次站上风口的前提。

在2019 年的一次主题演讲中,黄仁勋分享了NVIDIA一次次重溯行业的缘起——找到了真正重要的问题并坚持。他说:「这使我们能够一次又一次地发明、重塑我们的公司、重溯我们的行业。我们发明了GPU。我们发明了程式着色。是我们让电子游戏变得如此美丽。我们发明了CUDA,它将GPU 变成了虚拟实境的模拟器。」

回到NVIDIA的起点。当时Windows 3.1 刚刚问世,个人电脑革命才刚刚要开始。 NVIDIA想要能找到一种方法让3D 图形消费化、民主化,让大量的人能够接触到这项技术,从而创造一个当时不存在的全新行业——电子游戏。他们认为,如果做成,就有可能成为世界上最重要的技术公司之一。

原因在于:3D图形主要表现为对现实的模拟,对世界的模拟相当复杂,如果知道如何创建难辨真假的虚拟实境,在所做的一切中模拟物理定律,并将人工智慧引入其中,这一定是世界上最大的运算挑战之一。它沿途衍生的技术,可以解决惊人的问题。

最有代表性的案例,就是透过CUDA 等方案为运算、人工智慧等带来了革新性影响,也让它在这一波生成式AI浪潮中处于最佳生态位。

尽管GPU 作为运算设备的发现经常被认为有助于引领围绕深度学习的「寒武纪大爆炸」,但GPU 并不是单独工作的。 NVIDIA内外的专家都强调,如果NVIDIA在2006 年没有将CUDA 运算平台添加到组合中,深度学习革命就不会发生。

CUDA(Compute Unified Device Architecture)运算平台是NVIDIA于2006 年推出的软体和中介软体堆叠,其通用的平行运算架构能够使得GPU 解决复杂的运算问题。透过CUDA,研究人员可以程式设计和存取GPU 实现的运算能力和极致并行性。

而在NVIDIA发布CUDA 之前,对GPU 进行程式设计是一个漫长而艰巨的编码过程,需要编写大量的低阶机器码。使用免费的CUDA,研究人员可以在在NVIDIA的硬体上更快、更便宜地开发他们的深度学习模型。

CUDA 的发明起源于可程式化GPU 的想法。 NVIDIA认为,为了创造一个美好的世界,第一件要做的事情就是先类比它,而这些物理定律的模拟是个超级电脑负责的问题,是科学运算的问题,因此,关键在于:怎么把一个超级电脑才能解决的问题缩小、并放进一台正常电脑的大小,让你能先模拟它,然后再产生画面。这让NVIDIA走向了可程式化GPU,这是个无比巨大的赌注。

彼时,NVIDIA花了三四年时间研发CUDA,最后却发现所有产品的成本都不得不上升近一倍,而在当时也并不能给客户带来价值,客户显然不愿意买单。

若要让市场接受,NVIDIA只能提高成本,但不提高售价。黄仁勋认为,这是运算架构的事情,必须要让每一台电脑都能跑才能让开发者对这种架构有兴趣。因此,他继续坚持,并最终打造出了CUDA。但在那段时间,NVIDIA的利润「摧毁性」地下降,股票掉到了1.5 美元,并持续低迷了大约5 年,直到橡树岭国家实验室选择了NVIDIA的GPU 来建造公用超级电脑。

接着,全世界的研究人员开始采用CUDA 这项技术,一项接着一项的应用,一个接着一个的科学领域,从分子动力学、运算物理学、天体物理学、粒子物理学、高能物理学……这些不同的科学领域开始采用CUDA。两年前,诺贝尔物理学奖和化学奖得主,也都是因为有CUDA 的帮助才得以完成自己的研究。

当然,CUDA 也为NVIDIA的游戏提供了动力,因为虚拟世界里和现实世界的流体力学是一样的,像是粒子物理学的爆炸、建筑物的崩塌效果,和NVIDIA在科学运算中观察到的是一样的,都是基于同样的物理法则。

然而,CUDA 发布后的前六年里,NVIDIA并未「全力投入」AI,直到AlexNet 神经网路的出现。

在即将到来的GTC 大会上,黄仁勋邀请了OpenAI 联创兼首席科学家伊尔亚·苏兹克维(Ilya Sutskever),而苏兹克维见证了NVIDIA这段在人工智慧领域崛起的故事。

苏兹克维与亚历克斯·克里泽夫斯基(Alex Krizhevsky)及其博士老师杰佛瑞·辛顿(Geoffrey Hinton) 一起创建了AlexNet,这是电脑视觉领域开创性的神经网路,在2012 年10 月赢得了ImageNet 竞赛。获奖论文表明该模型实现了前所未有的图像辨识精度,直接导致了此后十年里人工智慧的主要成功故事——从Google Photos、Google Translate 和Uber 到Alexa 和AlphaFold 的一切。

根据辛顿的说法,如果没有NVIDIA,AlexNet 就不会出现。得益于数千个运算核心支援的并行处理能力,NVIDIA的GPU 被证明是运行深度学习演算法的完美选择。辛顿甚至在一次演讲上告诉在场的近千名研究人员都应该购买GPU,因为GPU 将成为机器学习的未来。

在2016 年接受富比士采访时,黄仁勋说自己一直都知道NVIDIA图形晶片的潜力不止于为最新的电玩游戏提供动力,但他没想到会转向深度学习。

事实上,NVIDIA的深度神经网路GPU 的成功是「一个奇怪的幸运巧合」,一位名叫Sara Hooker 的作者在2020 年发表的文章「硬体彩票」探讨了各种硬体工具成功和失败的原因。

她说,NVIDIA的成功就像「中了彩票」,这在很大程度上取决于「硬体方面的进展与建模方面的进展之间的正确对齐时刻」。这种变化几乎是瞬间发生的。 「一夜之间,需要13000 个CPU 的工作两个GPU 就解决了」她说。 「这就是它的戏剧性。」

然而,NVIDIA并不同意这种说法,并表示,从2000 年代中期开始NVIDIA就意识到GPU 加速神经网路的潜力,即使他们不知道人工智慧将成为最重要的市场。

在AlexNet 诞生的几年后,NVIDIA的客户开始购买大量GPU 用于深度学习,当时,Rob Fergus(现任DeepMind 研究科学家)甚至告诉NVIDIA应用深度学习研究副总裁Bryan Catanzaro,「有多少机器学习研究人员花时间为GPU 编写核心,这太疯狂了——你真的应该研究一下」。

黄仁勋逐渐意识到AI 是这家公司的未来,NVIDIA随即将把一切赌注押在AI 身上。

于是,在2014 年的GTC 主题演讲中,人工智慧成为焦点,黄仁勋表示,机器学习是「当今高性能运算领域最激动人心的应用之一」。 「其中一个已经取得令人兴奋的突破、巨大的突破、神奇的突破的领域是一个叫做深度神经网路的领域。」黄仁勋在会上说道。

此后,NVIDIA加快布局AI 技术,再也不只是一家GPU 计算公司,逐渐建立了一个强大的生态系统,包括晶片、相关硬体以及一整套针对其晶片和系统进行优化的软体和开发系统。这些最好的硬体和软体组合平台,可以最有效地生成AI。

可以说,GPU + CUDA 改变了AI 的游戏规则。中信证券分析师许英博在一档Podcast节目中评价道:NVIDIA一直在做一件非常聪明的事情,就是软硬一体。在GPU 硬体半导体的基础上,它衍生出来了基于通用运算要用的CUDA。这促成了NVIDIA拿到了软体和硬体的双重规模效应。

在硬体端,因为它是图形和运算的统一架构,它的通用性确保了它有规模性,而规模性摊薄了它的研发成本,所以硬体上本身通过规模性可以拿到一个比较优势的研发成本。

在软体端,因为它有庞大的开发者的生态,而这些宝贵的软体发展人员,即便是这些软体发展人员换了一个公司,但他可能还是在继续用CUDA 的软体。

您也可以联系文章作者本人进行修改,若内容侵权或非法,可以联系我们进行处理。

任何个人或组织,转载、发布本站文章到任何网站、书籍等各类媒体平台,必须在文末署名文章出处并链接到本站相应文章的URL地址。

本站文章如转载自其他网站,会在文末署名原文出处及原文URL的跳转链接,如有遗漏,烦请告知修正。

如若本站文章侵犯了原著者的合法权益,亦可联系我们进行处理。