5月29日,NVIDIA CEO黄仁勋在“COMPUTEX TAIPEI 2023”发表了开幕主题演讲,在与NVIDIA AI相关产品发布的公告中,需要注意的是NVIDIA 正式发布了搭载GH200的AI超级计算机“NVIDIA DGX GH200”(以下简称DGX GH200)。该计算机可以将256台GH200作为一个GPU流进行处理,实现了144TB内存、900GB/s的GPU带宽,而关键的AI性能,则达到了1EFLOPS,具备超级强大的AI性能,谷歌、Meta、微软有望成为第一批用户。

GH200是将Grace和Hopper两个模块集成到一起的电脑

NVIDIA发布的产品是一种用于超级计算机的模块,该模块整合了该公司开发的Arm CPU(Grace)和GPU(Hopper),以开发代号“Grace Hopper”而闻名,其正式名称为“NVIDIA GH200 Grace Hopper Superchip”。

Grace是NVIDIA开发的Arm架构CPU,采用了Arm公司已经发布的称为“Neoverse V2”的CPU IP设计。Neoverse V2不仅支持Armv9-A指令集架构,还具备128位SVE2引擎,支持扩展指令集,使得AI计算可以利用Bflot16和INT8等扩展指令集进行。在Grace中,每个芯片上搭载了72个这样的Neoverse V2 CPU核心(对于只有CPU的NVIDIA Grace CPU Superchip,则每个模块包含2个芯片,共计144个核心)。

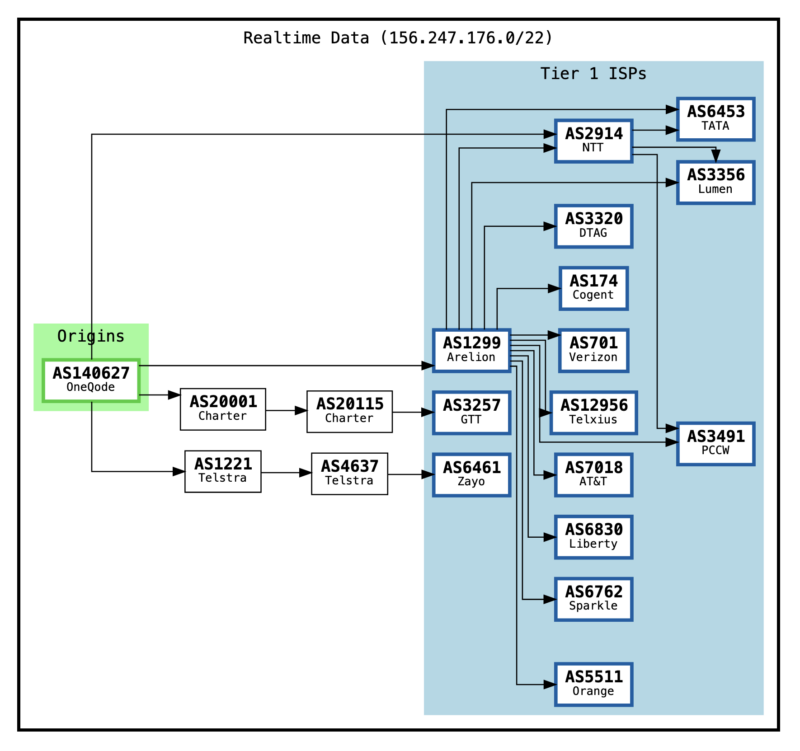

在Grace Hopper或GH200中,一个Grace芯片和一个Hopper GPU芯片被装载在一块模块上,并通过NVIDIA开发的专有互连技术“NVIDIA C2C(NVLink Chip-2-Chip)”相连接。其带宽达到了900GB/s,相比于PCI Express 5.0 x16的带宽,提高了7倍。

GH200的最大特点在于,其CPU主内存最大可达512GB(LPDDR5X),GPU内存为96GB(HBM3)。这96GB的GPU内存可以通过NVLink交换机将GH200相连接,最多可以连接256台计算机。

DGX GH200是一种由256台GH200的超级计算机,其性能达到了每秒1EFLOPS的水平

DGX GH200是一台真正的超级计算机,与以前的DGX系列产品略有不同的是,这代的DGX是以机架形式提供的。此外DGX GH200的定位也略有不同,而且DGX H100搭载了x86 CPU,这也是不同之处。

据NVIDIA称,DGX GH200搭载了256个GH200,CPU和GPU的总内存容量为144TB。对于搭载如此大容量内存的设备,NVIDIA超级计算/HPC副总裁Ian Buck表示:“使用生成AI或LLM等巨型模型进行计算的AI已经达到了内存容量成为性能瓶颈的地步。我们需要超过TB的巨型内存,通过利用CUDA的编程模型,实现一个巨大的GPU,来满足这种需求。”他强调,对于被认为是内存容量限制的瓶颈,DGX GH200将成为答案之一,特别是在使用生成AI或LLM等巨型AI模型进行计算的情况下。

据Buck介绍,DGX GH200的AI性能达到了1EFLOPS(=1,000PFLOPS),终于突破了Petascale的界限,进入了Exascale领域。计划到2023年底之前,DGX GH200将可用,首先在Google、Meta、Microsoft等云服务中可以试用。

MGX: 一种模块化存储CPU/GPU/DPU等的开放规范

NVIDIA公布了他们称之为“MGX”的模块式服务器机箱概念。目前的服务器机箱是以CPU为中心布置的,GPU和DPU(如果按照英特尔的说法,则为IPU)等则插入PCI Express扩展槽等中。虽然在重视通用服务器的CPU的情况下问题不大,但是在专注于AI处理的服务器中,存在着需要加装更多GPU等的需求,传统的以CPU为中心的服务器机箱的灵活性正在变得不足。

这些广告安全、信息丰富且有趣。请考虑关闭该网站的广告拦截器,些许广告收入有助于维持网站的活力,谢谢

请关闭广告拦截器

因此,NVIDIA提出的MGX是将CPU、GPU、DPU等模块化,更加方便地实现服务器的部署。这样一来,就可以在CPU中心的系统中加装更多的CPU,或者在使用同一机箱的情况下减少CPU并加装更多的GPU等,从而更加灵活地进行操作。

不过,目前MGX的机制尚未公开,NVIDIA解释说将在今后以白皮书等形式公布。此外,这个MGX是开放的规格,竞争对手也可以制作符合MGX规格的模块,向服务器厂商等提供。

您也可以联系文章作者本人进行修改,若内容侵权或非法,可以联系我们进行处理。

任何个人或组织,转载、发布本站文章到任何网站、书籍等各类媒体平台,必须在文末署名文章出处并链接到本站相应文章的URL地址。

本站文章如转载自其他网站,会在文末署名原文出处及原文URL的跳转链接,如有遗漏,烦请告知修正。

如若本站文章侵犯了原著者的合法权益,亦可联系我们进行处理。

hi8个月前0

请问有详细一点的自己搭建的教程吗你好9个月前0

你好,可以再帮我看看吗? 我已经按照你的方法设定了,还是一样,wordpress后台的 Purge Varnish Cache 插件还是清除不到cache,依旧显示 the varnish control terminal is not responding at。谢谢 https://mjj.today/i/Srk2Tz https://mjj.today/i/Srkcoi你好9个月前0

对,你说的没错,我配置的时候改了一些东西,现在我按照你的教学,可以启动了,网页可以缓存了,不过wordpress 清除cache 那个插件没用的,我输入本地回环地址127.0.0.1 :6082 ,再输入API key ,插件显示the varnish control terminal is not responding at 127.0.0.1:6082,就你图片那样,然后试一下点击清除cache 那里,他显示error,研究了一天,还是没有不行。你好9个月前1

你好,为啥我按照你的方法,到第三部分,去到真正后源的服务器设定Varnish 部分,我填了真正后源的IP跟端口跟域名,然后重启 Varnish ,就出现这样了? 这是怎么回事? 谢谢 [Linux] AMH 7.1 https://amh.sh [varnish-6.6 start] ================================================== =========== [OK] varnish-6.6 is already installed. Could not delete 'vcl_boot.1713549650.959259/vgc.sym': No such file or directory Error: Message from VCC-compiler: VCL version declaration missing Update your VCL to Version 4 syntax, and add vcl 4.1; on the first line of the VCL files. ('/home/usrdata/varnish/default.conf' Line 1 Pos 1) ... #--- Running VCC-compiler failed, exited with 2 VCL compilation failedchu9个月前0

很完善的教程‘hu9个月前0

我用gmail EMAIL_SERVER="smtp://********@gmail.com:bpyfv*********[email protected]:587"叽喳9个月前0

MAIL_SERVER="smtp://[email protected]:[email protected]:587" 大佬 这个使用outlook 或者gmail 是什么样子的格式? 邮寄已经开启smtp了hu9个月前0

输入框的问题解决了,我没有设置反代,NEXTAUTH_URL改为域名+端口就好了