本文只做部分摘录,本文作者:@tinychen,原文首发于:https://tinychen.com/20221209-k8s-10-deploy-ha-k8s-with-cilium-bgp/。文末结尾处将有跳转到作者首发链接以备查阅。

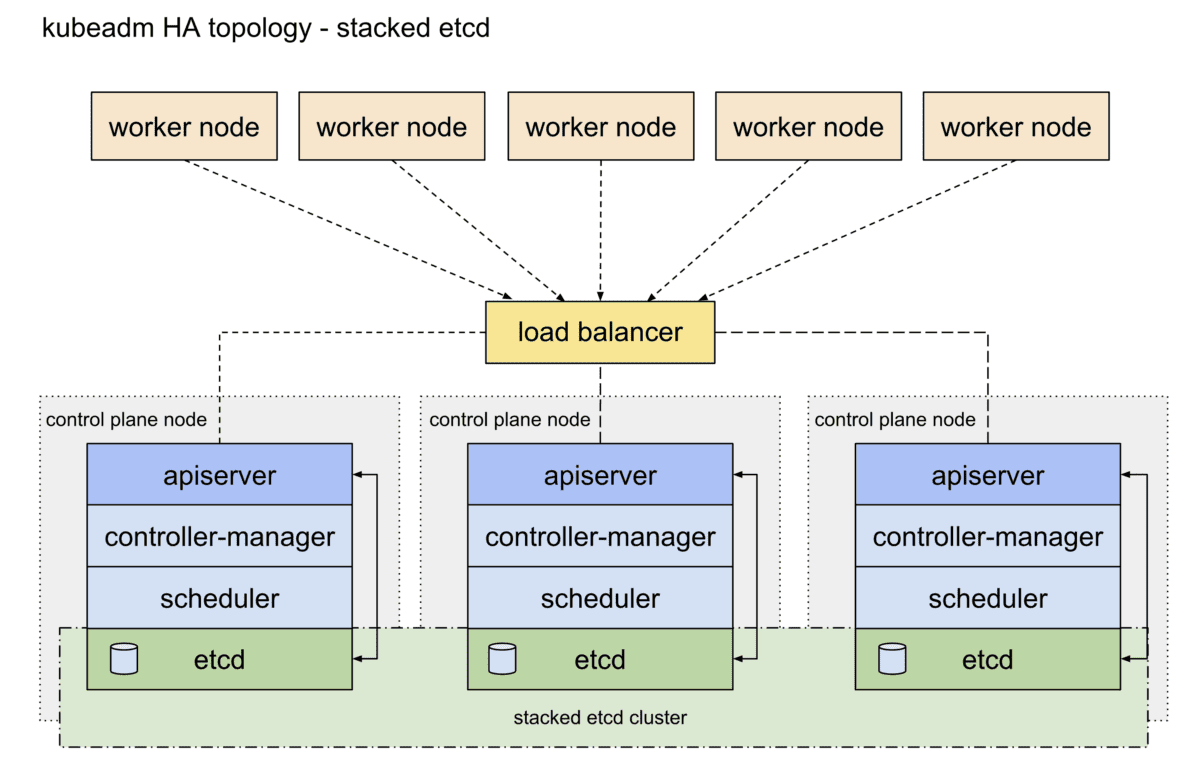

本文主要在centos7系统上基于containerd和stable版本(1.12.4)的cilium组件部署v1.25.4版本的堆叠ETCD高可用k8s原生集群,在LoadBalancer上选择了PureLB和kube-router结合cilium实现BGP路由可达的K8S集群部署。

此前写的一些关于k8s基础知识和集群搭建的一些方案,有需要的同学可以看一下。

1、准备工作

1.1 集群信息

机器均为16C16G的虚拟机,硬盘为100G。

IP Hostname

10.31.80.0 k8s-cilium-apiserver.tinychen.io

10.31.80.1 k8s-cilium-master-10-31-80-1.tinychen.io

10.31.80.2 k8s-cilium-master-10-31-80-2.tinychen.io

10.31.80.3 k8s-cilium-master-10-31-80-3.tinychen.io

10.31.80.4 k8s-cilium-worker-10-31-80-4.tinychen.io

10.31.80.5 k8s-cilium-worker-10-31-80-5.tinychen.io

10.31.80.6 k8s-cilium-worker-10-31-80-6.tinychen.io

10.32.0.0/17 podSubnet

10.32.128.0/18 serviceSubnet

10.32.192.0/18 LoadBalancerSubnet

1.2 检查mac和product_uuid

同一个k8s集群内的所有节点需要确保mac地址和product_uuid均唯一,开始集群初始化之前需要检查相关信息

# 检查mac地址

ip link

ifconfig -a

# 检查product_uuid

sudo cat /sys/class/dmi/id/product_uuid

1.3 配置ssh免密登录(可选)

如果k8s集群的节点有多个网卡,确保每个节点能通过正确的网卡互联访问

原文链接:https://tinychen.com/20221209-k8s-10-deploy-ha-k8s-with-cilium-bgp/

您也可以联系文章作者本人进行修改,若内容侵权或非法,可以联系我们进行处理。

任何个人或组织,转载、发布本站文章到任何网站、书籍等各类媒体平台,必须在文末署名文章出处并链接到本站相应文章的URL地址。

本站文章如转载自其他网站,会在文末署名原文出处及原文URL的跳转链接,如有遗漏,烦请告知修正。

如若本站文章侵犯了原著者的合法权益,亦可联系我们进行处理。

hi8个月前0

请问有详细一点的自己搭建的教程吗你好9个月前0

你好,可以再帮我看看吗? 我已经按照你的方法设定了,还是一样,wordpress后台的 Purge Varnish Cache 插件还是清除不到cache,依旧显示 the varnish control terminal is not responding at。谢谢 https://mjj.today/i/Srk2Tz https://mjj.today/i/Srkcoi你好9个月前0

对,你说的没错,我配置的时候改了一些东西,现在我按照你的教学,可以启动了,网页可以缓存了,不过wordpress 清除cache 那个插件没用的,我输入本地回环地址127.0.0.1 :6082 ,再输入API key ,插件显示the varnish control terminal is not responding at 127.0.0.1:6082,就你图片那样,然后试一下点击清除cache 那里,他显示error,研究了一天,还是没有不行。你好9个月前1

你好,为啥我按照你的方法,到第三部分,去到真正后源的服务器设定Varnish 部分,我填了真正后源的IP跟端口跟域名,然后重启 Varnish ,就出现这样了? 这是怎么回事? 谢谢 [Linux] AMH 7.1 https://amh.sh [varnish-6.6 start] ================================================== =========== [OK] varnish-6.6 is already installed. Could not delete 'vcl_boot.1713549650.959259/vgc.sym': No such file or directory Error: Message from VCC-compiler: VCL version declaration missing Update your VCL to Version 4 syntax, and add vcl 4.1; on the first line of the VCL files. ('/home/usrdata/varnish/default.conf' Line 1 Pos 1) ... #--- Running VCC-compiler failed, exited with 2 VCL compilation failedchu9个月前0

很完善的教程‘hu9个月前0

我用gmail EMAIL_SERVER="smtp://********@gmail.com:bpyfv*********[email protected]:587"叽喳9个月前0

MAIL_SERVER="smtp://[email protected]:[email protected]:587" 大佬 这个使用outlook 或者gmail 是什么样子的格式? 邮寄已经开启smtp了hu9个月前0

输入框的问题解决了,我没有设置反代,NEXTAUTH_URL改为域名+端口就好了